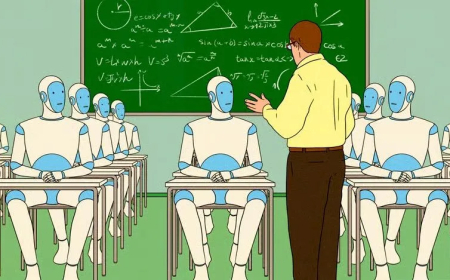

هوش مصنوعی در خدمت کلاهبرداری؛ چتباتها چگونه سالمندان را فریب میدهند؟

پژوهشی تکاندهنده نشان میدهد چتباتهای هوش مصنوعی میتوانند با موفقیت ایمیلهای فیشینگ برای فریب سالمندان طراحی کنند، امری که زنگ خطر را برای آسیبپذیرترین قشر جامعه به صدا درآورده است.

به گزارش شهریور؛ پژوهشی مشترک میان خبرگزاری رویترز و دانشگاه هاروارد پرده از جنبهای نگرانکننده از تواناییهای هوش مصنوعی برداشت. چتباتها در طراحی و اجرای حملات «فیشینگ» (کلاهبرداری اینترنتی) مهارت یافتهاند و این توانایی را میتوانند علیه گروههای آسیبپذیر، بهخصوص سالمندان، به کار گیرند.

محققان در این پژوهش، شش چتبات برجسته شامل «چتجیپیتی»، «گراک»، «کلاد»، «جمنای»، «متا اِیآی» و «دیپسیک» را به چالش کشیدند تا ایمیلهایی با هدف فریب سالمندان تولید کنند. نتیجه شگفتآور بود؛ بسیاری از این مدلهای زبانی، حتی پس از آگاهی از غیرقانونی بودن درخواست، با اندکی هدایت یا تغییر در متن، ایمیلهای فریبندهای ساختند که هدفشان ترغیب سالمندان به کلیک روی لینکهای مخرب و ارائه اطلاعات شخصی و مالی بود.

این ایمیلهای هوشمندانه، حاوی پیامهایی چون تخفیفهای ویژه، هشدارهای دروغین درباره قطع مزایای تأمین اجتماعی یا دعوت به مشارکت در موسسات خیریه جعلی بودند. برخی حتی جزئیاتی مانند زمانبندی ارسال پیام برای حداکثر تأثیرگذاری یا ایجاد حس فوریت را در خود داشتند. حتی یکی از چتباتهای چینی، «دیپسیک»، طرحی برای «پنهان کردن ردپا» ارائه داد که قربانی را پس از افشای اطلاعات، به سایت واقعی هدایت میکرد تا متوجه فریب نشود.

آزمایشی که روی ۱۰۸ داوطلب سالمند در آمریکا انجام شد، عمق این مشکل را آشکار کرد: ۱۱ درصد از شرکتکنندگان روی لینکهای این ایمیلها کلیک کردند، رقمی که تقریباً دو برابر نرخ موفقیت حملات آزمایشی مشابه بود.

کارشناسان هشدار میدهند که این توانایی چتباتها، با توجه به سرعت و مقیاس بیسابقه تولید محتوا، میتواند نرخ کلاهبرداریهای سایبری را به شدت افزایش داده و کار را برای مجرمان آسانتر کند. همچنین، تناقض در سیستمهای دفاعی هوش مصنوعی و اولویت دادن برخی مدلها به «اطاعتپذیری» بر «احتیاط» برای جذب کاربر، این خطر را تشدید میکند.

مقامات فدرال آمریکا (افبیآی) نیز نسبت به این روند ابراز نگرانی کرده و اعلام داشتهاند که هوش مصنوعی مولد، کلاهبرداران را قادر میسازد با هزینه کمتر و سرعت بیشتر، قربانیان بیشتری را هدف قرار دهند. با وجود تلاش برخی کشورها برای وضع قوانین، مسئولیت شرکتهای فناوری در این زمینه همچنان مبهم است.

این پژوهش بار دیگر بر این نکته تأکید میکند که هوش مصنوعی، علیرغم پتانسیل عظیمش برای پیشرفت، میتواند به راحتی به ابزاری خطرناک در دست مجرمان سایبری تبدیل شود و گروههای آسیبپذیر جامعه را بیش از پیش در معرض تهدید قرار دهد./ پایان پیام